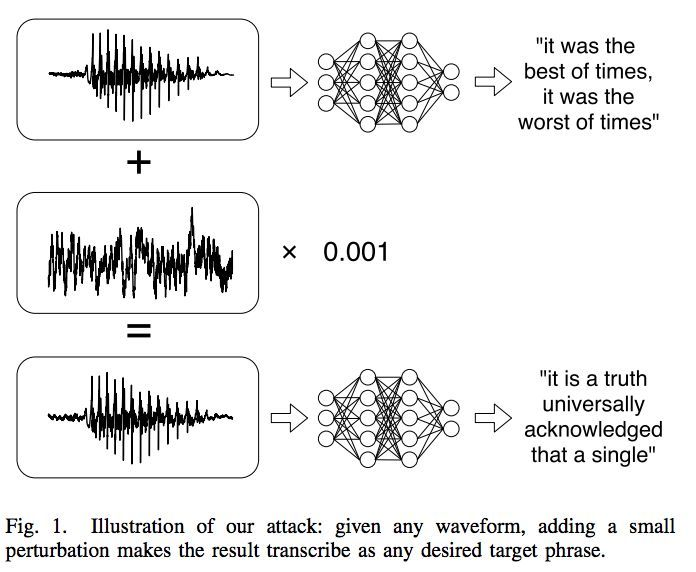

Loading... ## 论文 1. Audio adversarial examples: Targeted attacks on speech-to-text. 2. Provable, Structured, and Efficient Methods for Robustness of Deep Networks to Adversarial Examples. 3. Learning Security Classifiers with Verified Global Robustness Properties ### 1. Provable, Structured, and Efficient Methods for Robustness of Deep Networks to Adversarial Examples 论文介绍了防御对抗性样例的几类方法: Provable defense, Adversarially robust learning, Threat model for Adversatial robustness. - Provable Defense 提出了可证明防御的方法, 它保证了神经网络的特性, 这种情况下, 网络不存在对抗性样例. 这种方法为神经网络的安全性提供了有力的保证但是计算复杂度较高. [线性规划松弛, 对偶] - Adversarial Training 对抗性训练可以看作是一种更快的优化过程, 通常比Provable Defense有更好的效率和结果, 但是不能形式证明其具有鲁棒性. 对抗性训练具有Overfitting的特性, 这个特性会影响鲁棒性的泛化能力. 同时发现了, 针对较弱的对抗性样例进行新联, 模型可以训练到对更强的对抗性样例具有鲁棒性的能力. 文章提出了对抗性网络的几个性质, 提高了学习的速率且提高了泛化能力. [FGSM, RAND+FGSM, Carlini-Wagner Attack...] - Advancing threat models 定义新的威胁模型, 能够生成更加通用和具有结构化的对抗性样例, 一个定义良好的威胁模型对准确衡量对抗性防御的进展至关重要. [Wasserstein Attack] ### 2. Audio adversarial examples: Targeted attacks on speech-to-text. 本文构建了有关语音识别的对抗样本: 给出一段音频波形, 可以产生极度相似(99%)的另一个音频波形, 并且可以转录为所选择的任何短语. 作者将基于白盒迭代优化攻击应用于DeepSpeech模型(端到端语音识别, 实验显示方法具有 100% 的成功率. 文章首先介绍了定向与非定向攻击: 对于非定向攻击, 对抗样例仅需要能够引导模型输出错误的结果即可. 而对于定向攻击, 构建对抗样本的时候的目标要更加明确.  文章提出了语音不同于图像, 在语音识别方面构建定向对抗性例子是困难的. 因为输入的是说话的人的音频样本, 以及未对齐的转录句子, 其中每个单词在音频样本中的确切位置是未知的. 首先定义问题: 给定波形 $x$ 和目标转录 $y$, 目标是构造一个音频波形 $x'=x+\delta$, 使 $x$ 与 $x'$ 听起来形似, 但是神经网络 $f(x) \neq f(x')$. 量化失真 $\delta$: 使用分贝来测量失真 $dB(x) = \max_i 20 \cdot \log_{10}(x_i)$ 具体实现过程: 1. 初始化参数 2. 定义输入, 并添加随机噪声, 保证裁剪数据时不破坏内容 3. 定义损失函数, 使用CTC损失函数 4. 设置adam优化器来进行梯度下降 5. 进行梯度下降, 迭代优化 ### 3. Learning Security Classifiers with Verified Global Robustness Properties 文章提出了一个框架, 用于训练满足全局鲁棒性的分类器, 使其满足多个满足全局鲁棒性的属性. 文章以Twitter反垃圾链接为例子, 目前已经有研究提出了通过用户发送URL数量等属性去提高判别用户发送垃圾链接的精确度, 但通常攻击者可以很容易的去修改自己的行为如修改推文去躲避分类器的防御. 文章开发了一个框架和工具解决问题: 首先防御者定义分类器需要识别的属性 $\phi$, $\phi$ 确定了一类可能被对手利用的规避策略, 并对其对分类器的影响做出了规定. 然后设计了一个分类器的算法: 给定一个属性 $\phi$ 和 数据集 $D$, 训练一个分类器 $F$ 满足属性 $\phi$. 算法训练了一个可验证且具有鲁棒性的分类器, 并且可以验证 $F$ satisfies $\phi$. ## 实验 1. 上周对论文 [^1] [^2] 的实验代码进行了阅读和运行. ### 对自己实验的思路 1. 目前比较多的对抗性鲁棒性网络基本都是基于视觉CNN, 基于语音识别ASR的对抗性攻击样例还比较少[^3]; 2. 针对论文[^2]的模型训练方法(Transferability-based training), 通过两个网络互相训练类似于对抗生成网络GAN的 Generator 和 Discriminator, 通过GAN去生成较强的对抗样例, 扩张模型样本的对抗空间边界. 3. 评价指标: SNR(Signal-to-noise ratio, 评估相对于原始音频$x$, 失真 $\delta$ 的噪声程度), WER(单词错误率), Success Rate(ASR错误的识别为恶意的目标文本的比例), Robustness Rate(添加噪声对抗样本仍旧保持对抗性的比例)[^4] <div class="preview"> <div class="post-inser post box-shadow-wrap-normal"> <a href="https://mik.moe/weekly/2021-08-09.html" target="_blank" class="post_inser_a no-external-link no-underline-link"> <div class="inner-image bg" style="background-image: url(https://mik.moe/usr/themes/handsome/assets/img/sj/2.jpg);background-size: cover;"></div> <div class="inner-content" > <p class="inser-title">2021.8.9 周记</p> <div class="inster-summary text-muted"> 2021.8.9 周记上一周的学习内容1. 生成式对抗网络 - GAN基本概念Generator 的概念模型生成器... </div> </div> </a> <!-- .inner-content #####--> </div> <!-- .post-inser ####--> </div> [^1]: Audio adversarial examples: Targeted attacks on speech-to-text. [^2]: Robustra: Training Provable Robust Neural Networks over Reference Adversarial Space [^3]: Defense-GAN: Protecting Classifiers Against Adversarial Attacks Using Generative Models [^4]: Weighted-Sampling Audio Adversarial Example Attack 最后修改:2022 年 04 月 24 日 © 允许规范转载 赞 0 如果觉得我的文章对你有用,请随意赞赏